J’ai commencé à m’intéresser aux technologies du Web sémantique en 2005 et j’ai fait ma première communication à ce sujet en 2006 lors de la conférence Digital Humanities à Paris. J’ai eu l’occasion de les tester grandeur nature dès 2007 pour un projet mené par le CCH du King’s college, mais c’est au cours du projet SPAR de la Bibliothèque nationale de France à partir de 2008 que j’ai véritablement commencé à toucher du doigt les formidables promesses de ces technologies ainsi que leurs limites, déjà… Entre 2008 et 2014, j’ai eu l’occasion de les déployer dans différents contextes pour répondre à des cas d’usage divers : exposition des données, récupération de données encodées au sein des pages Web, décloisonnement de silos internes et mise en cohérence de données, enrichissement de données et mashup… J’ai œuvré à leur diffusion, du moins j’ai essayé, à travers ce blog ou ailleurs, et effectué quantité de formations sur le sujet en direction de publics très variés. Pour résumer, j’y voyais alors le moyen de déployer un système d’information orienté données et plus uniquement processus et d’une manière générale de renverser ce primat dans la manière d’aborder le développement d’une application informatique.

Comme je l’ai déjà expliqué, à l’issue de cette période, j’étais très dubitatif sur l’intérêt d’utiliser ces technologies. Dans la mesure où j’étais conscient de leurs apports mais aussi de leurs limites, elles étaient toujours présentes mais sans être jamais au cœur de ma réflexion à l’Ina, du moins directement. L’expérience accumulée et les bénéfices de ces technologies nourrissaient néanmoins des pans entiers de la stratégie que nous étions en train de déployer sans même que j’en sois totalement conscient.

C’est peut-être la raison pour laquelle j’ai continué de les enseigner aussi bien dans le Master « Technologies numériques appliquées à l’histoire » de l’Ecole nationale des chartes que lors de formations pour Ina Expert, parfois, il faut bien l’avouer, en traînant un peu les pieds. J’ai fait évoluer ma présentation en replaçant ces technologies et leur intérêt dans le contexte plus large du Big Data, de l’Open Data et maintenant de l’intelligence artificielle. Finalement, je ne me suis jamais résolu à les abandonner totalement, partant du principe qu’une technologie ne disparaît pas, mais trouve sa juste place par rapport aux autres. De plus, je reste convaincu qu’elles restent la meilleure technologie pour assurer l'interopérabilité des données, mais jusqu’à quel point en a-t-on vraiment besoin ?

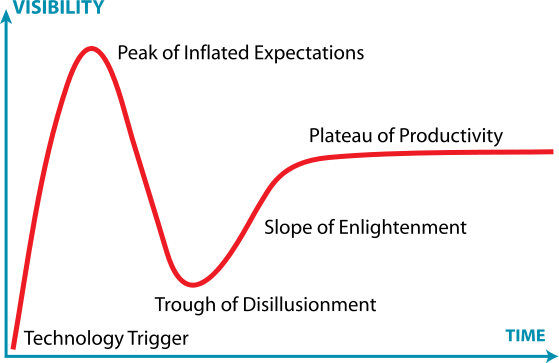

Plusieurs fois, à la lecture d’un article ou d’un tweet qui vantaient les mérites de ces technologies et du Linked Open Data ou web de données, j’ai voulu écrire pourquoi il fallait rester prudent (voire plus…), encore récemment autour de la question de leurs usages au sein des musées. Je l’ai même dit en conférence, parfois, de manière abrupte, à la hauteur des désillusions que j’avais vécues. Aujourd’hui, sans avoir réussi à s’imposer largement, ces technologies ont indubitablement fait avancer notre réflexion sur la question de l’interopérabilité et force est de constater que certaines initiatives ont réussi à sortir du lot et à valider certains usages. Après avoir laissé passer le « ravin de la désillusion » et au moment où ces technologies semblent atteindre le plateau de la productivité du « Hype cycle », c’est le bon moment de dresser un bilan.

Hype Cycle du Gartner, Jérémy Kemp, CC-BY-SA

Alors, peut-être pour la dernière fois sur ce blog, je vous propose une plongée dans les entrailles des technologies du Web sémantique pour étudier quels en sont finalement les apports et les limites et l’écart entre les promesses et la réalité. Pour rendre les choses un peu plus digeste à lire et à appréhender, j’ai séparé ce bilan en quatre billets :